在近日举行的Amazon Web Services re:Invent 2024大会上,亚马逊云科技展示了其在加速计算和生成式人工智能领域的最新进展。此次大会聚焦于如何利用亚马逊云科技的基础设施,构建和扩展大规模生成式AI模型,并探索了其在不同行业中的应用案例。

亚马逊云科技介绍了其加速计算产品组合的最新动态,包括基于GPU和亚马逊云科技AI芯片的实例。这些实例为客户提供了高效、低成本的解决方案,以支持从大型语言模型到多模态语言模型的训练和推理任务。会上,多个领先企业分享了如何利用亚马逊云科技在生成式AI领域取得突破性成果的真实案例。

在医疗保健领域,Amgen等公司利用基于Transformer的模型设计蛋白质,加速了药物发现过程。这些模型能够学习蛋白质的生物学语言,生成新药物和疗法的候选者。大型语言模型(LLM)也被用于简化电子病历的文档编制和处理,减轻了医疗保健系统的行政负担。

在工业和汽车领域,生成式AI被集成到机器人技术中,提高了机器人的安全性和效率。法拉利等公司利用生成式AI设计汽车,通过3D渲染让客户在车辆生产前进行可视化,从而重塑了客户体验。在金融服务行业,一些公司对年报和财务报表进行LLM微调,使数据更易于投资者获取。亚马逊推出的GPT基础网站助手Rufus,则通过训练产品目录和客户评论,为客户提供个性化的购物建议。

在媒体和娱乐行业,Adobe等公司正在创建多模态模型,使用户能够通过简单的文字输入创建电影体验。这一创新从根本上改变了创作过程,创作者可以与智能模型对话,快速创建、迭代和完善图像和视频内容。

亚马逊云科技观察到,LLM训练规模持续增长,最大训练任务已使用超过10,000个GPU进行同步分布式工作负载。同时,全球范围内的LLM推理需求也显著增加,即使是偏远地区的用户也能实时与行业最强大的模型互动。2024年预计将是多模态LLM的崛起之年,这些模型能够处理视听信息,对计算基础设施提出了更高要求。

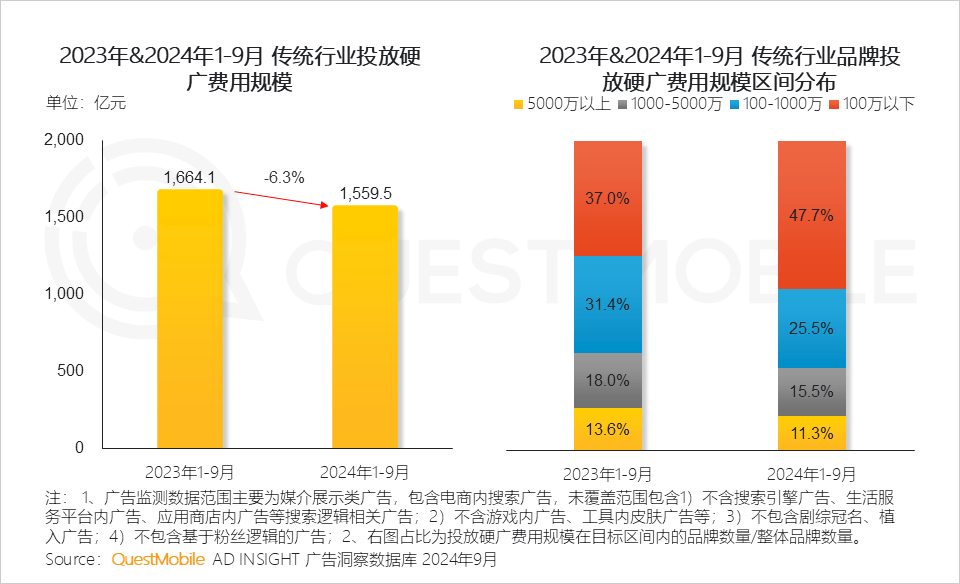

为了满足这些需求,亚马逊云科技提供了全面的加速计算实例组合,包括NVIDIA GPU驱动的G系列和P系列实例,以及定制的AI加速器如Inferentia和Trainium。其中,新推出的Trainium 2芯片驱动的Trn2实例,每个加速器配备96GB内存,支持高达1.5TB的聚合高带宽内存,专为大型模型训练设计。

在网络方面,亚马逊云科技设计了SRD协议,支持大规模分布式工作负载的高效、可靠和安全传输。新推出的P5bn实例进一步优化了EFA网络,提高了分布式训练的性能。亚马逊云科技还提供了丰富的存储选项,包括本地实例存储、EBS和S3等,以满足客户在不同工作负载中的需求。

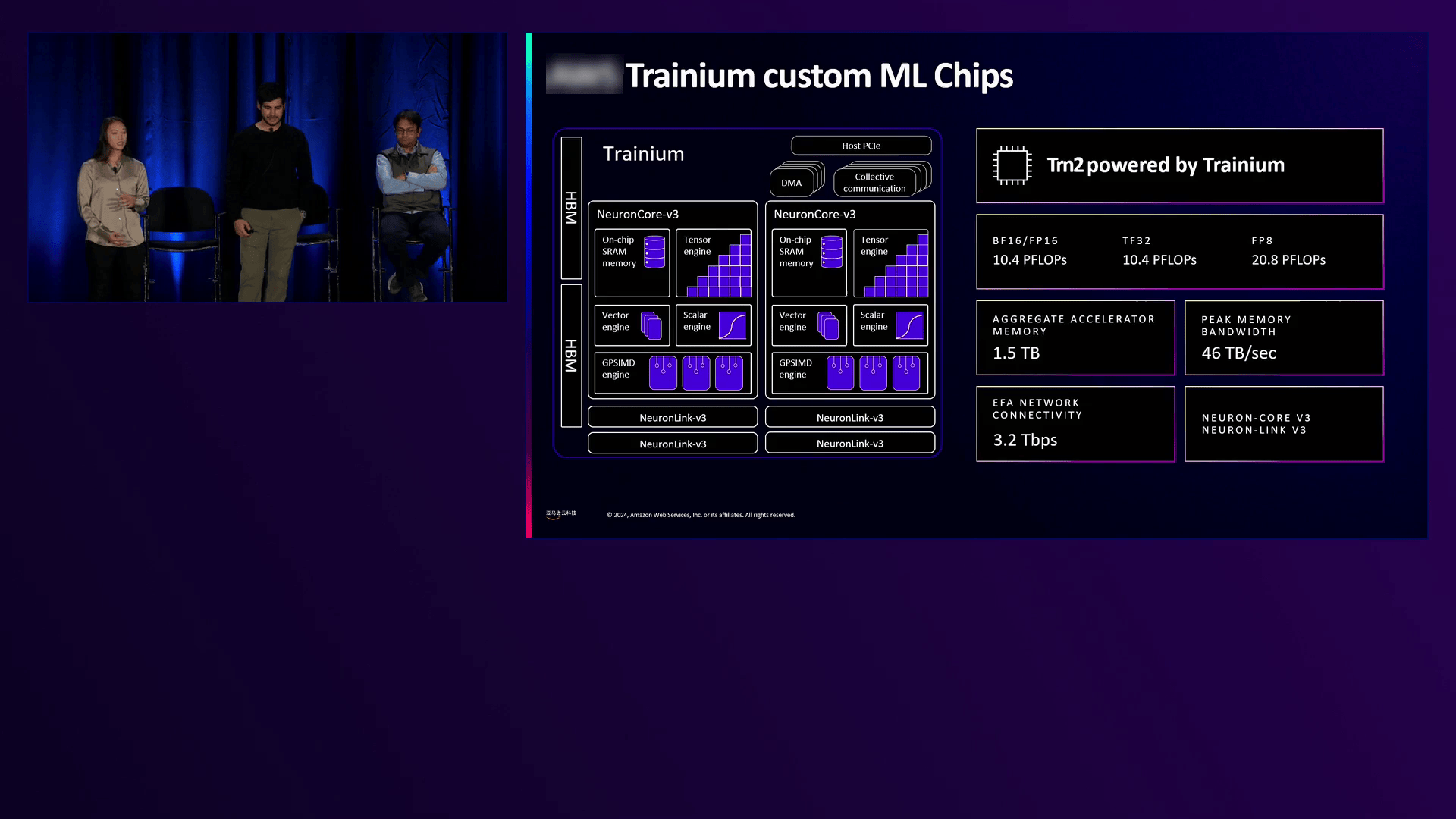

亚马逊云科技还强调了安全性在生成式AI中的重要性。通过Nitro System等安全功能,确保计算环境的安全性。Nitro TPM能够测量和验证部署代码的完整性,为客户提供更大的信任保证。亚马逊云科技还提供了诸如VPC加密等服务,确保数据在传输和存储过程中的安全性。

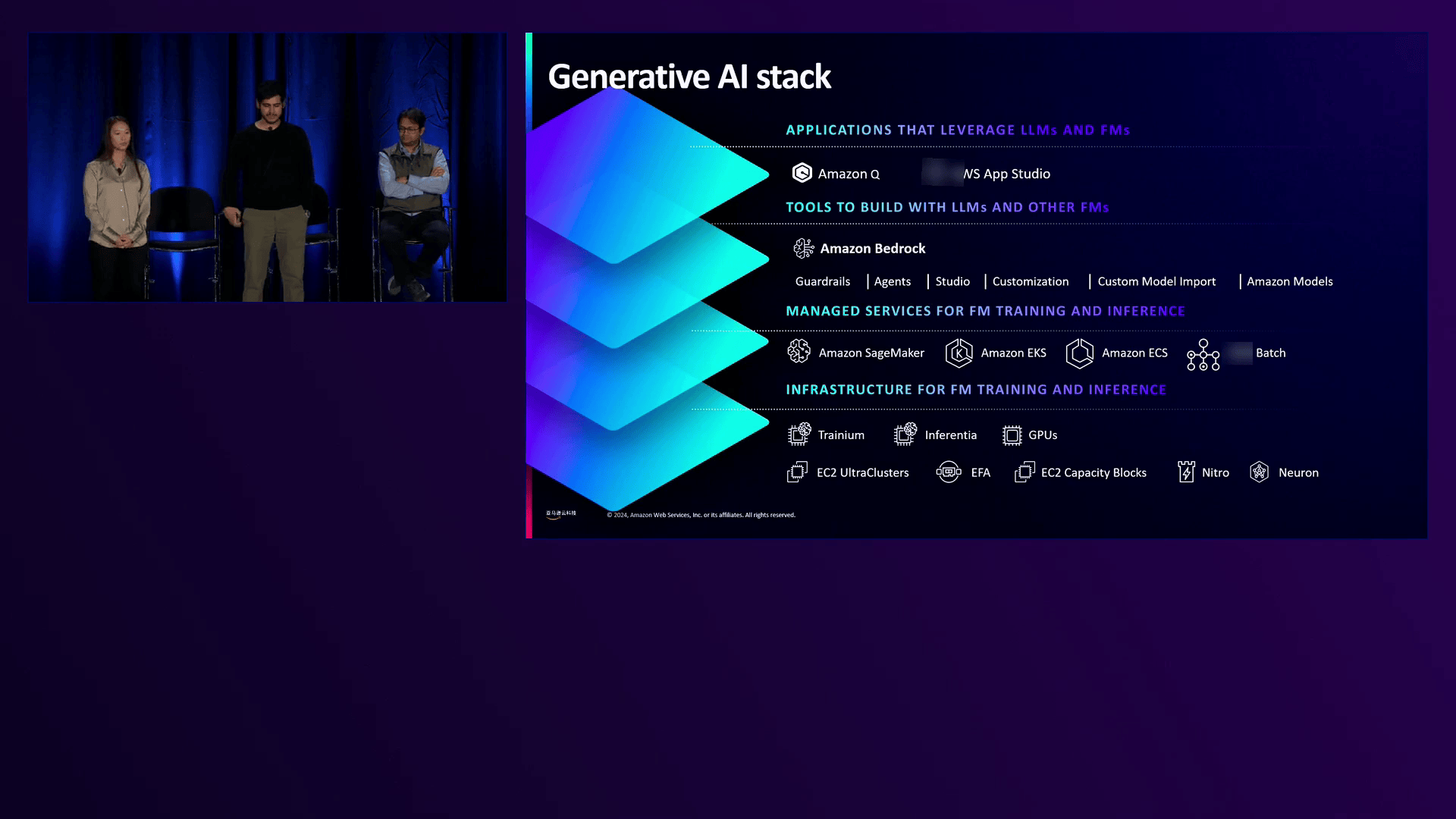

在生成式AI技术栈方面,亚马逊云科技提供了SageMaker等托管服务,帮助客户高效地准备数据、训练模型和部署模型。SageMaker Studio等工具提供了可扩展的数据清理和错误检测功能,简化了模型开发过程。Bedrock等服务简化了对预训练语言模型的微调和部署过程,使客户能够快速启动并运行生成式AI应用。

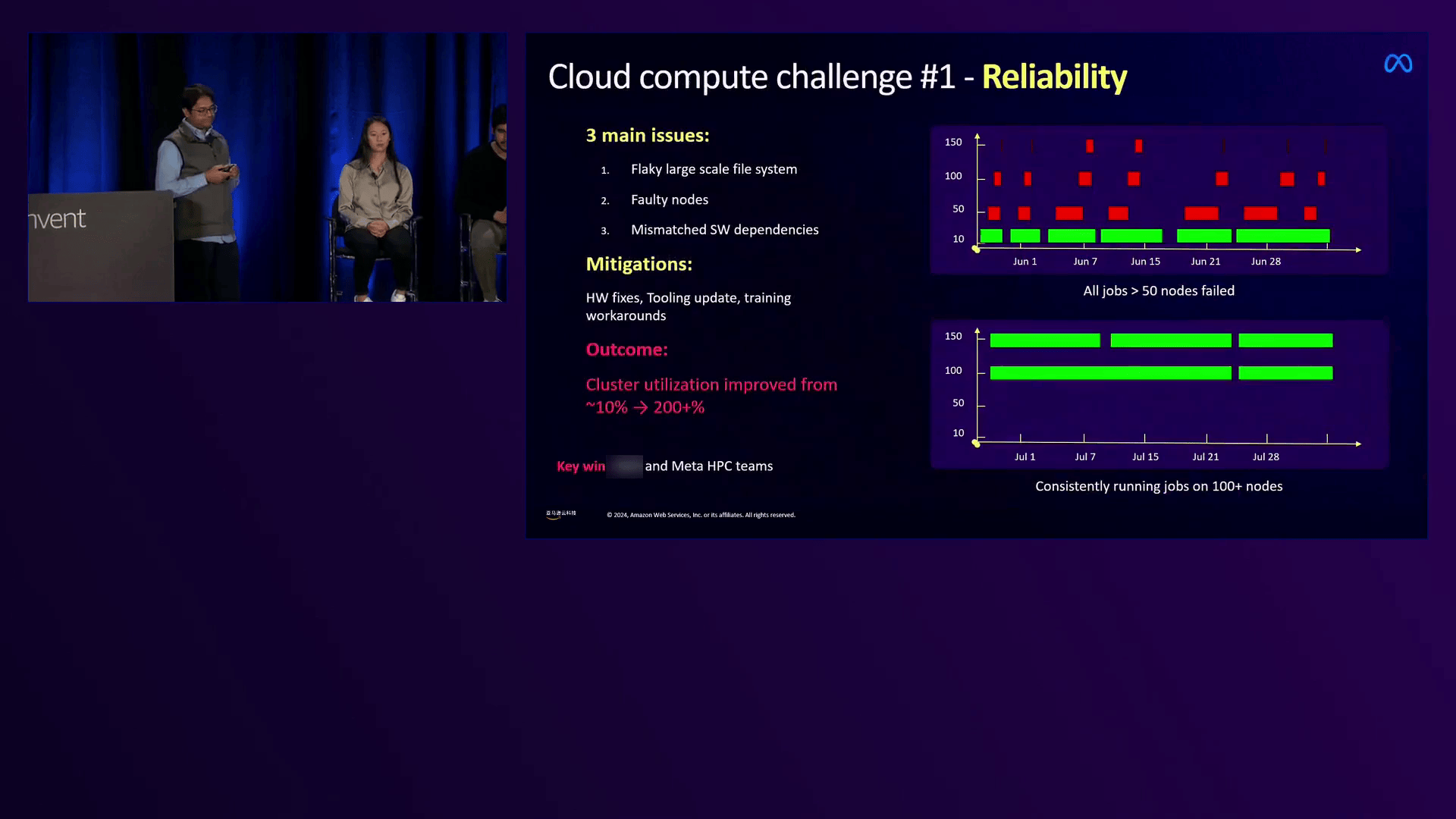

meta的Kirimani分享了其团队如何利用亚马逊云科技构建多模态LLM的经验。他们通过快速原型设计和实验选择了合适的架构,并在亚马逊云科技的计算基础设施上进行了大规模训练。这一过程中,他们克服了文件系统故障、节点故障等挑战,成功将模型扩展到数十亿参数规模。亚马逊云科技的计算能力、可靠性和可扩展性对meta实现其智能眼镜的愿景至关重要。

通过此次大会,亚马逊云科技展示了其在加速计算和生成式AI领域的领先地位。随着生成式AI技术的不断发展,亚马逊云科技将继续创新并提供更高效的解决方案,支持客户在各个领域取得突破性成果。